从社交媒体和电子商务到高级计算机视觉应用,图像裁剪在许多情况下都是一项必不可少的任务。裁剪有助于保持图像质量,避免不必要的调整大小,因为调整大小会降低图像质量并消耗计算资源。当图像需要符合预定的宽高比(例如缩略图)时,裁剪也很有用。

过去十年,世界各地的工程师开发了各种机器学习 (ML) 模型来自动裁剪图像。这些模型旨在以保留最相关部分的方式裁剪输入图像。

然而,这些模型可能会出错并表现出偏见,在最坏的情况下,可能会使用户面临法律风险。例如,2020 年,有人对 X(前身为 Twitter)提起诉讼,因为其自动裁剪功能隐藏了转发图片中的版权信息。

因此,了解图像裁剪 ML 模型失败的原因至关重要,这样才能相应地训练和使用它们并避免此类问题。

在此背景下,日本同志社大学的一个研究团队着手开发新技术来为图像裁剪任务生成对抗性样本。

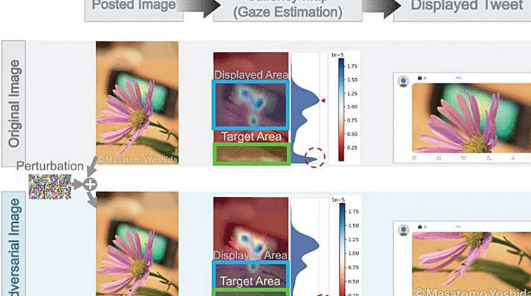

正如他们在 2024 年 6 月 17 日发表在IEEE Access上的论文中所解释的那样,他们的方法可以在图像中引入难以察觉的噪声扰动,以诱使模型裁剪符合用户意图的区域,即使原始模型会错过它。

该研究的第一作者兼首席研究员、博士生 Masatomo Yoshida 表示:“据我们所知,针对图像裁剪模型的对抗性攻击的研究很少,因为之前的大多数研究都集中在图像分类和检测上。这些模型需要改进,以确保它们尊重用户的意图,并在裁剪图像时尽可能消除偏见。”

日本京都同志社大学理工学研究生院的 Masatomo Yoshida 和 Haruto Namura 以及同志社大学理工学院的 Masahiro Okuda 也参与了这项研究。

研究人员开发并实施了两种不同的生成对抗性示例的方法——白盒方法和黑盒方法。

白盒方法需要访问目标模型的内部工作原理,涉及根据模型的梯度迭代计算输入图像的扰动。

通过使用凝视预测模型来识别图像中的显著点,该方法可以操纵凝视显著图以获得有效的对抗性示例。它显著减少了扰动大小,在整个实验图像数据集中,其最小尺寸比基线方法小 62.5%。

黑盒方法利用贝叶斯优化来有效缩小搜索空间并瞄准特定图像区域。与白盒策略类似,此方法涉及基于凝视显著图的迭代程序。

它不使用内部梯度,而是采用树状结构的 Parzen 估计器来选择和优化影响凝视显著性的像素坐标,最终生成所需的对抗性图像。值得注意的是,黑盒技术在现实世界场景中的适用范围更广,在网络安全环境中具有更大的相关性。

根据实验结果,这两种方法都显示出了良好的前景。正如参与这项研究的研究生 Haruto Namura 所解释的那样,“我们的研究结果表明,我们的方法不仅超越了现有技术,而且还有望成为现实世界应用的有效解决方案,例如 Twitter 等平台上的应用。”

总体而言,这项研究代表着朝着更可靠的人工智能系统迈出了重大一步,这对于满足公众的期望和赢得他们的信任至关重要。提高生成图像裁剪对抗样本的效率将推动机器学习的研究,并启发解决其紧迫挑战的解决方案。

名村和吉田的顾问 Masahiro Okuda 教授总结道:“通过识别日益部署的人工智能模型中的漏洞,我们的研究有助于开发更公平的人工智能系统,并满足日益增长的人工智能治理需求。”