布里斯托尔计算机科学学院的科学家在解决人工智能“幻觉”问题和提高关键国家基础设施(CNI)中异常检测算法的可靠性方面取得了重大进展。

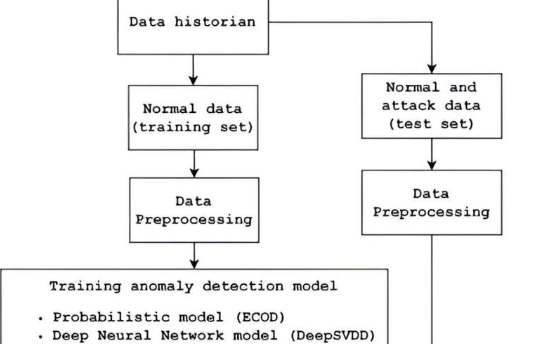

人工智能的最新进展凸显了该技术在异常检测方面的潜力方面的潜力,特别是在CNI的传感器和执行器数据中。然而,这些人工智能算法通常需要大量的训练时间,并且很难精确定位异常状态中的特定组件。此外,人工智能的决策过程通常不透明,导致人们对信任和责任的担忧。

为了解决这个问题,该团队采取了一系列措施来提高效率,包括:

可解释的AI集成:为了提高透明度和信任度,团队将可解释的AI模型与异常检测器集成在一起。这种方法可以更好地解释AI决策,使人类操作员能够在做出关键决策之前理解和验证AI建议。还评估了各种XAI模型的有效性,从而深入了解哪些模型最有助于人类理解。

以人为本的决策:该研究强调了人类监督在人工智能驱动的决策过程中的重要性。通过向人类操作员解释人工智能的建议,该团队旨在确保人工智能充当决策支持工具,而不是不容置疑的预言家。这种方法引入了问责制,因为人类操作员根据人工智能的见解、政策、规则和法规做出最终决策。

评分系统开发:正在开发一个有意义的评分系统,以衡量人工智能解释的正确性和可信度。该分数旨在帮助人类操作员衡量人工智能驱动的见解的可靠性。

这些进步不仅提高了CNI中AI系统的效率和可靠性,而且还确保了人类操作员仍然参与决策过程,从而增强了整体责任感和信任度。

这项研究的共同作者SaradVenugopalan博士解释说:“人类通过长时间的重复学习,工作时间较短,不容易出错。这就是为什么在某些情况下,我们会使用可以在很短时间内完成相同任务且错误率较低的机器。

“然而,这种涉及网络和物理组件的自动化,以及随后使用人工智能来解决自动化带来的一些问题,被视为一个黑匣子。这是有害的,因为使用人工智能建议的人员要对他们做出的决定负责,而不是人工智能本身。

“在我们的工作中,我们使用可解释的人工智能来提高透明度和信任度,因此使用人工智能的人员在做出决定之前就会了解到人工智能为什么做出建议(针对我们的领域用例)。”

这项研究是MathurosKornkamon硕士论文的一部分,由SridharAdepu博士指导。该论文发表在《第10届ACM网络物理系统安全研讨会论文集》上。

Adepu博士补充道:“这项研究探索了WaXAI如何利用可解释的人工智能彻底改变工业系统中的异常检测。通过集成XAI,人类操作员可以获得清晰的洞察力,并增强信心来处理关键基础设施中的安全事件。”