人工智能(AI)系统能力的增强让人们认为这些系统可能很快就会有意识。然而,我们可能低估了人类意识背后的神经生物学机制。

现代人工智能系统能够做出许多令人惊奇的行为。例如,当人们使用像ChatGPT这样的系统时,响应(有时)非常像人类和智能。当我们人类与ChatGPT交互时,我们有意识地感知语言模型生成的文本,就像您当前在这里有意识地感知该文本一样。

问题是当我们提示时,语言模型是否也能感知我们的文本。或者它只是一个僵尸,基于聪明的模式匹配算法工作?根据它生成的文本,人们很容易认为系统可能有意识。

JaanAru、MatthewLarkum和MacShine发表在《神经科学趋势》杂志上的新研究从神经科学的角度回答了这个问题。

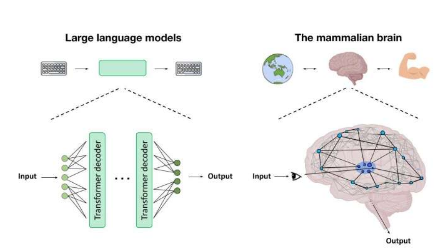

三位神经科学家认为,虽然像ChatGPT这样的系统的反应看起来是有意识的,但它们很可能不是。首先,语言模型的输入缺乏我们与周围世界的感官接触所特有的具体、嵌入的信息内容。其次,当今人工智能算法的架构缺少与哺乳动物意识相关的丘脑皮质系统的关键特征。

最后,导致有意识生物体出现的进化和发展轨迹可以说与今天所设想的人工系统没有相似之处。生物体的存在取决于它们的行为,它们的生存与多层次的细胞、细胞间和有机体过程错综复杂地联系在一起,最终形成能动性和意识。

因此,虽然人们很容易认为ChatGPT和类似的系统可能是有意识的,但这会严重低估我们大脑中产生意识的神经机制的复杂性。研究人员对于意识如何在我们的大脑中产生并没有达成共识。我们所知道的以及这篇新论文所指出的是,这些机制可能比当前语言模型背后的机制复杂得多。

例如,正如这项工作所指出的,真实的神经元与人工神经网络中的神经元不同。生物神经元是真实的物理实体,可以生长和改变形状,而大型语言模型中的神经元只是无意义的代码片段。在理解意识之前,我们还有很长的路要走,因此,距离有意识的机器还有很长的路要走。